В середине прошлого века гениальный математик Алан Тьюринг задался вопросом: может ли машина мыслить? Под этим он понимал способность компьютеров имитировать человеческое поведение — немыслимая для того времени идея. Для проверки гипотезы Тьюринг разработал тест, который задал критерии оценки искусственного интеллекта. Несмотря на критику, этот метод повлиял на развитие машинного обучения и до сих пор используется в исследованиях ИИ.

В чем суть теста Тьюринга

В 1950 году в философском журнале Mind вышла статья Алана Тьюринга «Вычислительные машины и разум». В этой работе ученый описывает два варианта эксперимента, о третьей модификации он рассказал в эфире радио BBC в 1952 году.

- В первой версии теста ученый опирался на популярную в то время игру в имитацию. На вечеринках гости обменивались письменными сообщениями с двумя собеседниками: мужчиной и женщиной. Их задача — угадать пол игроков, задавая любые вопросы. При этом мужчина пытается всех запутать, а женщина — помочь разобраться. Вероятность верного ответа — 50%.

Тьюринг предложил место мужчины отдать компьютеру. Если гости, не зная о подмене, будут ошибаться так же часто, можно считать, что машина обладает интеллектом.

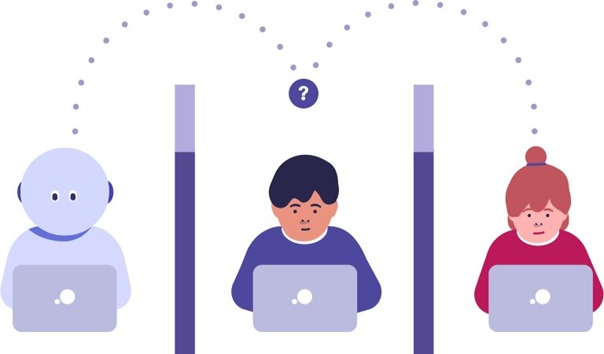

- Второй вариант теста стал классической интерпретацией эксперимента. Три участника: исследователь, человек и компьютер, находятся в разных помещениях и общаются только текстом. Цель исследователя — определить кто есть кто. При этом между сообщениями проходят равные промежутки времени, чтобы скорость реакции не стала подсказкой. Во времена Тьюринга люди отвечали быстрее машин, а теперь наоборот.

Компьютер успешно проходит тест, если исследователь ошибается в половине случаев. В отличие от первой версии, машина не просто заменяет одного из участников, а соревнуется с человеком в правдоподобности своих ответов.

- В третьей модификации теста Тьюринг сузил эксперимент до диалога человека и машины. В этом варианте группа исследователей письменно общается с респондентом, но не знает наверняка, с кем имеют дело. Эксперимент можно считать успешным, если 30% жюри приняли компьютер за живого собеседника. При таком подходе возможности машины оцениваются отдельно, без сравнения с человеком.

Какие алгоритмы справились с тестом Тьюринга

Долгое время разработчикам не удавалось создать алгоритм, который смог бы обмануть жюри. Но с развитием технологий, появились успешные примеры. Вот некоторые из них.

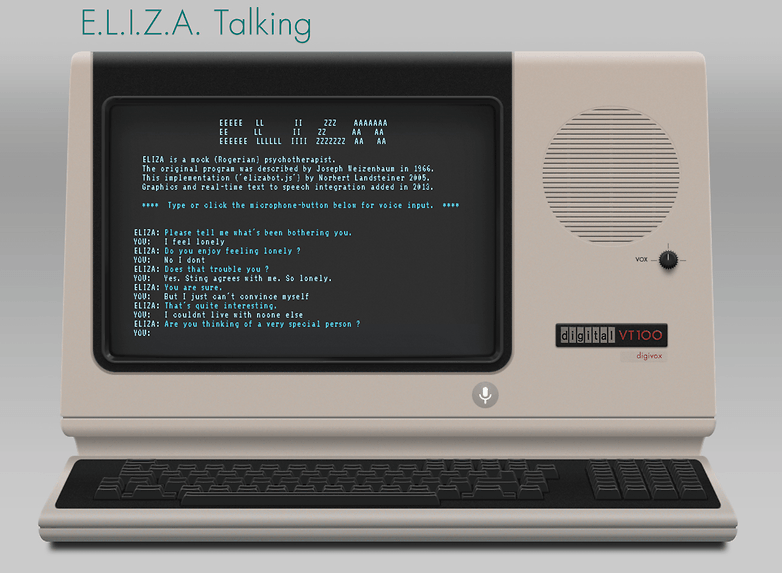

Eliza (1966). Джозеф Вейценбаум создал алгоритм, который играл роль психотерапевта. В работе с клиентом эти специалисты часто задают вопросы, перефразируя слова собеседника или просят привести пример ситуации. Вейценбаум учел эту особенность и разработал шаблон, по которому строились ответы. Люди верили, что общаются с психологом, поэтому Eliza назвали первым алгоритмом, который прошел тест Тьюринга. Но вывод спорный — клиентов не предупреждали, что они могут переписываться с ботом.

Parry (1972). Психиатр из Стэнфордского университета Кеннет Колби разработал программу, которая моделировала мышление человека с параноидальной шизофренией. Для проверки ее способностей организовали эксперимент с участием опытных психиатров. Первая группа специалистов пообщались с реальными пациентами и Parry по телетайпу. Протоколы встреч распечатали и передали второй группе для оценки. В ответах алгоритма считывались агрессия и подозрительность, и в итоге, 52% врачей приняли бота за человека.

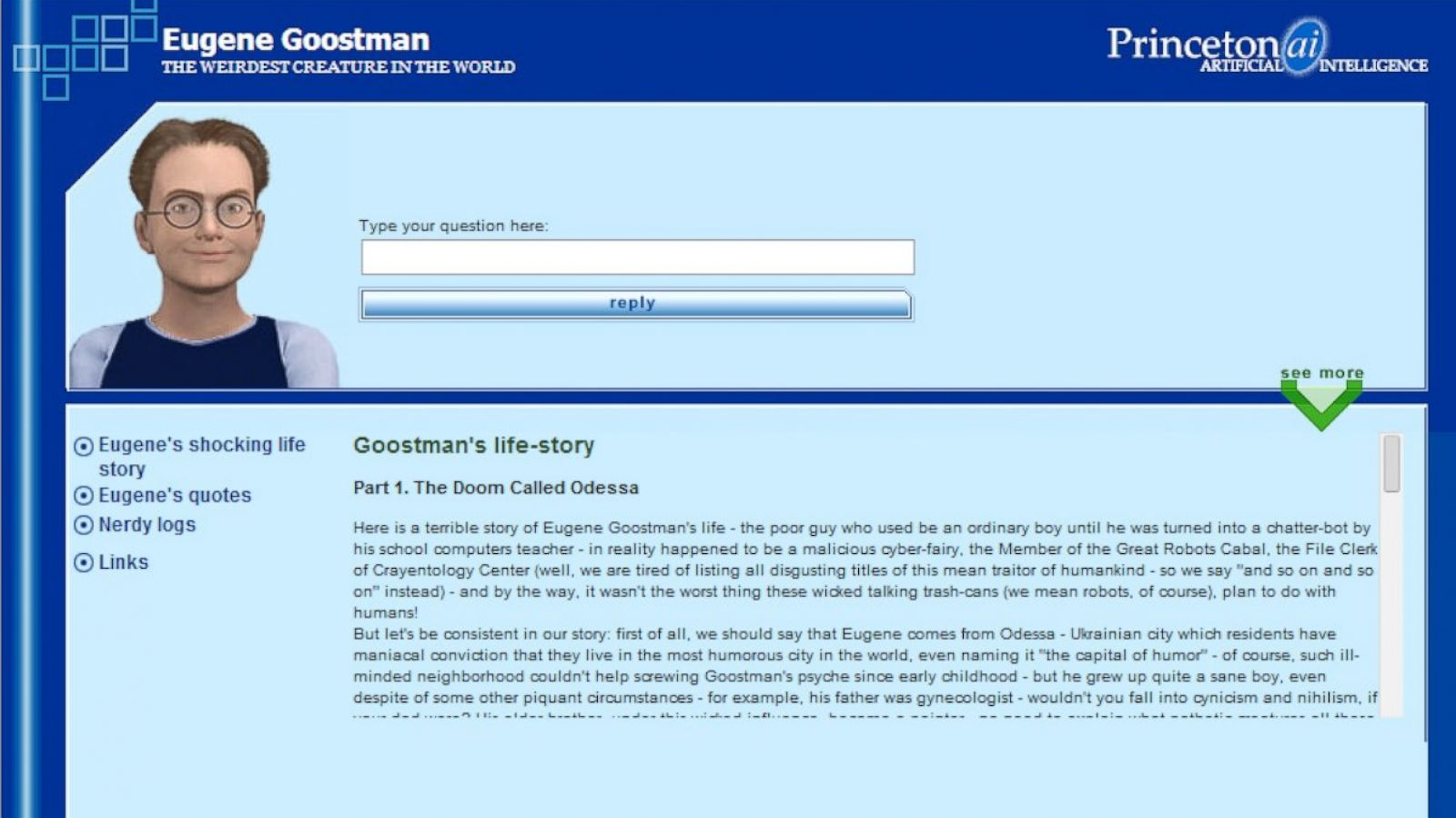

Eugene Goostman (2014). Владимир Веселов и Евгений Демченко создали алгоритм, который 33% жюри приняли за подростка из Одессы. Это был первый случай, когда компьютер прошел тест Тьюринга в формате живого диалога. Но и здесь не обошлось без уловок. Образ 13-летнего мальчика из другой страны скрывал ограничения программы. Судьи с пониманием отнеслись к плохому английскому и ошибкам в ответах респондента.

Google Duplex (2018). Голосовой помощник без проблем записался в салон красоты — администратор даже не заподозрила, что общается по телефону с ИИ. Разговор проходил перед аудиторией в 7000 человек. Многие посчитали, что алгоритм успешно прошел тест Тьюринга, хотя разработчики не ставили такой цели.

GPT-3 и ChatGPT (2020–2022). Современные языковые модели строят более правдоподобные и естественные ответы. Чат-боты от OpenAI официально не проходили тест Тьюринга, однако энтузиасты проверяют их способности самостоятельно. Например, израильская компания AI21 Labs запустила онлайн-игру, в которой поучаствовали 1,5 миллиона человек. Цель — за две минуты определить, с кем вы общаетесь: компьютером или живым собеседником. Игроки правильно определяли ботов в 60% случаев.

За что критикуют тест Тьюринга

Тьюринг задумывал свой тест, как способ определить, может ли машина думать. Но эксперты считают, что способность имитировать разум — это еще не мышление.

Одно из самых известных возражений — мысленный эксперимент «Китайская комната» философа Джоном Серла. Представьте, что человек, не знающий китайского языка, сидит в комнате с инструкцией по сборке иероглифов. Он получает листы с набором символов, подбирает ответы по заданным правилам и передает их обратно. Наблюдателя снаружи кажется, что человек понимает язык, но на самом деле он лишь следует алгоритму. Серл считал, что также работают и компьютеры: они манипулируют символами, но не понимают их смысла.

Еще один недостаток теста Тьюринга — его узкая направленность. Эксперимент проверяет способность ИИ к диалогу, но не оценивает другие аспекты интеллекта: понимание контекста, эмоции, творчество или самосознание. Хотя современные чат-боты справляются с тестом, это не делает их разумными — алгоритмы формулируют ответы на основе анализа паттернов речи.

Третий и, пожалуй, самый неожиданный аргумент против теста Тьюринга — вычислительные способности машин давно превосходят человеческие. Если цель разработчика — создать машину, не отличимую от живого собеседника, возможности бота придется искусственно ограничивать. Энциклопедические знания и моментальные ответы выдадут ИИ, и алгоритм не пройдет проверку. С практической точки зрения у таких уловок нет особого применения.

Эксперты в области ИИ Стюарт Рассел и Питер Норвиг считают: важно не просто имитировать интеллект, а понять его принципы. Здесь можно провести аналогию с авиацией: люди научились летать, изучая аэродинамику, а не копируя поведение птиц.

Альтернативы тесту Тьюринга

Схема Винограда — метод, названный в честь исследователя ИИ Терри Винограда. В 2012 году группа ученых во главе с Эктором Левеском придумали способ проверить, как бот понимает контекст. В тесте используются предложения с двойным смыслом, где правильный ответ зависит от логики. Например: «Кубок не влез в чемодан, потому что он слишком большой. Что “он” — кубок или чемодан?» Человек легко понимает, что речь идет о кубке, а компьютер может запутаться.

Тест Лавлейс 2.0 проверяет способность ИИ к творчеству. В оригинальной версии 2001 года, компьютер считается разумным, если может создать понятное и эстетичное произведение искусства. Но из-за отсутствия четких критериев оценки, тест посчитали некорректным. В 2014 году его доработали: теперь боты должны творить в определенных рамках. Например, создавать картины по мотивах Босха или писать музыку в стиле Майкла Джексона.

Визуальный тест Тьюринга исследует, может ли компьютер «видеть» как человек. В программу загружают картинку и спрашивают, где находится определенный предмет. Для ответа боту нужно выбрать несколько верных вариантов. Например, чашка стоит на блюдце, справа от блокнота, выше клавиатуры. Умение анализировать положение объектов относительно друг друга — важнейший навык человеческого разума.

Тест Маркуса — способ узнать, понимают ли боты юмор, сарказм и иронию. Ученый-когнитивист Гэри Маркус предположил, если бот сумеет найти в телешоу и мультсериалах смешные моменты и обосновать их, машину можно считать разумной.

Тест на обобщение придумали исследователи из Facebook AI Research в 2019 году. Они проверяли, как хорошо ИИ умеет применять знания на практике. Машине давали набор фактов, а затем просили сделать вывод. Например, если алгоритм знает, что кит — млекопитающее, он должен догадаться, что они дышат воздухом. Если ИИ не может сделать такой логический вывод, значит, он не осознает смысл информации, а просто оперирует данными.

Как используют тест Тьюринга сегодня

Самый известный пример — CAPTCHА. По сути — это обратный тест Тьюринга, который помогает интернет-сервисам отличать людей от ботов. Когда пользователи отмечают на картинке все изображения со светофорами, они доказывают компьютеру, что являются людьми.

Другая сфера применения — кибербезопасность и разработка чат-ботов. Компании проверяют, насколько правдоподобно их алгоритмы имитируют диалог с клиентом. Некоторые банки и онлайн-сервисы анализируют поведение пользователей, чтобы выявлять автоматизированные атаки.

Новые вызовы для ИИ

Хотя тест Тьюринга остается важной вехой в истории искусственного интеллекта, он устарел. Современные алгоритмы анализируют контекст, поддерживают диалог и уверенно проходят проверку. Так, ChatGPT-4 оказался настолько хорош, что его внедрили в компьютерные игры, чтобы пользователи могли общаться с персонажами-ботами. Однако, машины по-прежнему не могут считаться разумными существами.

Новое направление в области ИИ — развитие когнитивных способностей чат-ботов. Франсуа Шале разработал тест ARC-AGI для проверки уровня абстрактного мышления компьютеров. Он состоит из графических задач, для решения которых нужно найти закономерности в орнаментах. То, что люди делают интуитивно, машины способны решить только после предварительного обучения на массивах данных. Если бот пройдет тест без подготовки, можно будет говорить о настоящем интеллекте, а не его имитации.