Разберем роль модели MapReduce в составе Hadoop, а также расскажем, как использовать его отдельно и насколько это эффективно.

Что такое MapReduce

MapReduce — это модель распределенных вычислений, которая параллельно обрабатывает большие объемы данных, разделяя процессы вычисления между множеством серверов.

Модель разработали инженеры Google Джефф Дин и Санджей Гемойват в 2004 году. Она должна была автоматизировать обработку веб-страниц и создание индекса поисковой системы. В итоге MapReduce лег в основу Apache Hadoop — одной из популярных платформ для обработки больших данных.

Структура и принцип работы Hadoop (включая MapReduce)

Hadoop использует распределенные вычисления, когда данные и вычислительные процессы разделены между множеством серверов, объединенных в кластер (группу). Кластер состоит из узлов и хранилища данных.

Узлы

Узел — это отдельный сервер или вычислительный блок в кластере, который выполняет часть общей задачи по обработке данных. На узлах выполняются задачи MapReduce (Map → Shuffle → Reduce), про которые расскажем ниже.

Узлы можно разделить на две группы:

- Master-узел (JobTracker и Resource Manager)

Это основной управляющий узел, который отвечает за распределение задач и управление процессами вычислений.

Компоненты

- JobTracker (Hadoop 1.x)

В старой версии Hadoop (1.x) JobTracker был основным управляющим узлом. Его задача заключалась в том, чтобы:

- получать задачи от пользователя;

- разбивать эти задачи на более мелкие части (или подзадачи);

- отправлять эти подзадачи на исполнение на рабочие узлы (TaskTracker);

- следить за состоянием задач и управлять их выполнением.

- Resource Manager и Application Master (Hadoop 2.x и выше)

В более новых версиях Hadoop (2.x и далее) с внедрением фреймворка YARN (Yet Another Resource Negotiator) роль JobTracker перераспределили на два компонента:

- Resource Manager, который управляет распределением ресурсов (например, памяти и процессорного времени) между задачами;

- Application Master, который контролирует выполнение конкретных приложений (работает с задачами).

- Worker-узлы (TaskTracker или Node Manager)

Это узлы, которые непосредственно выполняют вычисления и обработку данных. В старых версиях Hadoop (1.x) их называли TaskTracker, а в более новых версиях (Hadoop 2.x и выше) — Node Manager.

Эти узлы отвечают за выполнение фаз Map (создание пар «ключ — значение») и Reduce (агрегация пар по ключам).

Хранилище

Для хранения данных в Hadoop используется распределенная файловая система, такая как HDFS (Hadoop Distributed File System). Она хранит большие объемы данных, разделяя их на блоки и распределяя эти блоки по различным узлам кластера.

HDFS — это основное хранилище данных в экосистеме Hadoop, но существуют и другие решения, например:

- Amazon S3 — облачное хранилище от Amazon, которое также поддерживает MapReduce-задачи;

- Google Cloud Storage — аналогичное хранилище для Google Cloud, которое также можно использовать для распределенной обработки данных.

HDFS распределяет данные по блокам (обычно размером 128 MB или 256 MB), которые затем копируются на несколько узлов для обеспечения отказоустойчивости: если один узел выходит из строя, копии блоков на других узлах продолжат использоваться для обработки данных.

Этапы обработки данных

MapReduce выполняет обработку данных в три этапа: Map, Shuffle и Reduce. Рассмотрим каждый из них на примере обработки текста.

Допустим, у нас есть предложение:

«Обработка данных важна, а MapReduce упрощает обработку данных».

- Map (разделение и обработка данных)

На этом этапе модель разбивает входные данные на небольшие фрагменты (split), потом передает каждый фрагмент на отдельный узел для обработки функцией map.

Что такое split?

Это процесс разделения данных на части. Текстовые данные обычно делят по строкам или словам.

Что делает функция map?

Функция map получает один фрагмент данных, анализирует его и преобразует в пары (ключ — значение).

Каждый узел обрабатывает свой фрагмент, преобразуя его в пары ключ — значение. В примере ниже ключом будет слово, а значением — единица 1 (одно вхождение слова).

Пример

("Обработка", 1)

("данных", 1)

("важна", 1)

("а", 1)

("MapReduce", 1)

("упрощает", 1)

("обработку", 1)

("данных", 1)

2. Shuffle (группировка и сортировка данных)

После этапа Map все промежуточные данные группируют и сортируют по ключам. На этом этапе одинаковые ключи передают в одни и те же узлы для дальнейшей обработки.

Пример

("а", [1])

("MapReduce", [1])

("важна", [1])

("данных", [1, 1])

("обработка", [1])

("обработку", [1])

("упрощает", [1])

В предложении слово «данных» встречается дважды, поэтому его значения объединились в список [1, 1].

3. Reduce (агрегация и вычисление результата)

Функция reduce суммирует количество вхождений каждого слова.

Пример

("а", 1)

("MapReduce", 1)

("важна", 1)

("данных", 2)

("обработка", 1)

("обработку", 1)

("упрощает", 1)

Слово «данных» встречается дважды, поэтому его итоговое значение — 2. После завершения этапа Reduce результаты сохраняются в хранилище (например, в HDFS).

MapReduce: установка, настройка и пример задачи

MapReduce можно использовать отдельно от Hadoop, его принципы (Map и Reduce) можно реализовать в любом языке программирования.

Но в таком случае мы лишаемся встроенного хранилища HDFS и системы управления ресурсами YARN. Распределение данных и вычислений приходится организовывать самостоятельно или с помощью других инструментов.

Например, Apache Spark и Dask предоставляют альтернативные фреймворки для распределенных вычислений, а облачные сервисы, такие как Google Cloud Dataflow или AWS Lambda, предлагают управляемые решения для обработки данных.

Выбор среды выполнения

Перед началом работы нужно выбрать, как именно использовать MapReduce:

- Локально для тестирования или небольших задач

В этом случае сложная настройка не требуется, а задача выполняется на одном компьютере. Однако производительность будет ограничена мощностью одной машины, не будет автоматического распределения нагрузки, а масштабирование возможно только за счет более мощного оборудования.

- В кластере с использованием Spark, Dask или вручную через распределенные узлы

Можно обрабатывать большие объемы данных, распределяя вычисления между несколькими узлами. Это ускорит выполнение задач. При этом настройка и управление кластером требуют дополнительных усилий, а также необходимо учитывать затраты на оборудование и поддержку инфраструктуры.

- В облаке с Google Cloud Dataflow, AWS Lambda и аналогами

Удобно тем, что инфраструктура управляется автоматически, а масштабирование происходит динамически в зависимости от нагрузки. Однако такие решения могут быть дорогостоящими при больших объемах данных.

Установка и настройка

Установка зависит от выбранной среды выполнения.

- Локальный запуск

Для локального запуска необходимо установить язык программирования, поддерживающий многопоточные или многопроцессорные вычисления, например Python, Java или Scala. В Python можно использовать библиотеки multiprocessing или dask, в Java — ForkJoinPool, а в Scala — Akka или встроенные механизмы параллелизма.

- Кластерное окружение

Для кластерного окружения требуется развернуть Spark- или Dask-кластер: установить фреймворк, настроить master- и worker-узлы, а также конфигурацию сетевого взаимодействия между ними.

В случае Spark также потребуется настроить YARN или Kubernetes для управления ресурсами.

- Облачное окружение

Нужно создать и настроить аккаунт в выбранном облачном сервисе и загрузить данные.

Написание простой MapReduce-задачи без Hadoop

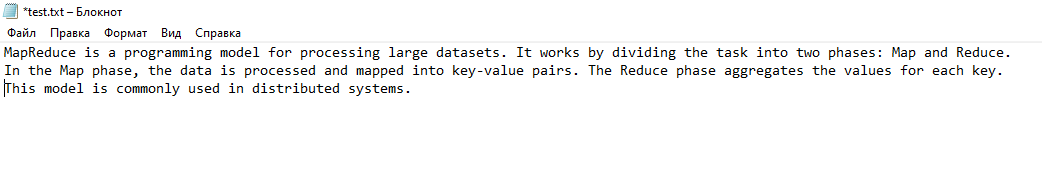

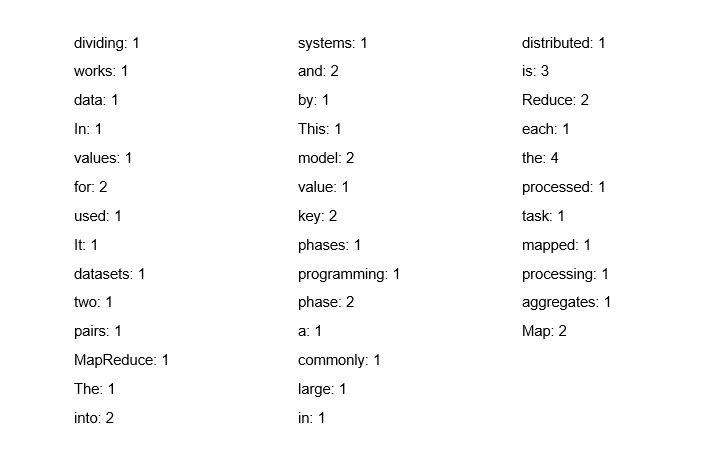

Для примера возьмем простейший вариант — считать текстовый файл, подсчитать количество вхождений слов и вывести результат.

Реализуем эту задачу с помощью Java. Убедитесь, что на вашем компьютере установлены Java Development Kit (JDK) и Maven (либо Gradle).

Особенности подхода:

— Не нужно устанавливать и настраивать Hadoop.

— Работать будем на одном компьютере, используя многопоточность для параллельного выполнения задач.

— Это решение не получится масштабировать на несколько машин, а также не выйдет использовать распределенное хранилище.

— Если данные станут слишком большими для одного компьютера, производительность упадет.

Алгоритм действий такой:

- Map. Прочитать файл, разбить его на слова, каждому слову присвоить значение 1.

- Reduce. Для каждого слова посчитать сумму значений.

Приступаем к написанию задачи.

- Сперва сделаем импорт необходимых библиотек.

import java.io.*; import java.util.*; import java.util.concurrent.*; import java.util.stream.*;

- Объявим класс WordCount и классический метод main с указанием нужных исключений.

public class WordCount {

public static void main(String[] args) throws IOException, InterruptedException, ExecutionException {

- Задаем путь к файлу, который будем обрабатывать. Вместо ‘your_file.txt’ нужно указать путь к нужному файлу.

String filePath = "your_file.txt";

- Используем метод Files.readAllLines(), который считывает все строки из файла и сохраняет их в список lines. Каждая строка — это один элемент в списке.

List<String> lines = Files.readAllLines(Paths.get(filePath));

- Создаем потом из строк в файле и разделяем текст на слова.

List<String> words = lines.stream()

.flatMap(line -> Arrays.stream(line.split("\\W+")))

.collect(Collectors.toList());

.stream() — создает поток из строк, прочитанных из файла.

.flatMap(line -> Arrays.stream(line.split(«\\W+»))) — для каждой строки из файла мы разбиваем ее на слова.

Разделение происходит по любым несловесным символам (через регулярное выражение \\W+, что означает «не-слово»).

.collect(Collectors.toList()) — собирает все слова из потока в список.

- Задаем количество потоков для обработки (в данном случае 4).

int numThreads = 4;

- Создаем интерфейс ExecutorService с пулом потоков для выполнения задач параллельно.

ExecutorService executor = Executors.newFixedThreadPool(numThreads);

Executors.newFixedThreadPool(numThreads) создает пул с фиксированным количеством потоков, равным numThreads.

- Создаем список futures для хранения результатов выполнения каждой задачи.

List<Future<Map<String, Integer>>> futures = new ArrayList<>();

- Разбиваем список слов на части (чанки), которые будут обрабатываться в отдельных потоках.

int chunkSize = words.size() / numThreads;

- Далее создаем цикл, выполняющийся до тех пор, пока не пройдем через все доступные потоки, которые нам нужно создать.

Это количество потоков указано в переменной numThreads.

for (int i = 0; i < numThreads; i++) {

int start = i * chunkSize;

int end = (i == numThreads - 1) ? words.size() : (i + 1) * chunkSize;

List<String> chunk = words.subList(start, end);

futures.add(executor.submit(() -> countWords(chunk)));

}

Каждый чанк содержит подсписок из исходного списка words. Мы делим слова на равные части, используя переменные start и end, и передаем эти части в каждый поток.

Каждая задача, которая выполняется в потоке, вызывает метод countWords(chunk), который подсчитывает количество слов в чанке.

- Создаем метод countWords, который принимает список слов (из одного чанка) и создает карту (Map), где ключом будет слово, а значением — количество его вхождений в этом чанке.

private static Map<String, Integer> countWords(List<String> words) {

Map<String, Integer> wordCount = new HashMap<>();

for (String word : words) {

wordCount.put(word, wordCount.getOrDefault(word, 0) + 1);

}

return wordCount;

}

С помощью wordCount.getOrDefault(word, 0) + 1 для каждого слова проверяем, сколько раз оно встречалось до этого. Если слово встречается впервые, возвращается 0 (по умолчанию), иначе увеличивается на 1.

- В main методе продолжаем после цикла for: ожидаем завершения задачи с помощью объекта future.get().

Map<String, Integer> finalWordCount = new HashMap<>();

for (Future<Map<String, Integer>> future : futures) {

Map<String, Integer> result = future.get();

result.forEach((key, value) -> finalWordCount.merge(key, value, Integer::sum));

}

Объект future — это результат выполнения асинхронной задачи.

Каждая задача возвращает карту с результатами, которые мы объединяем. Мы используем метод merge(), чтобы сложить значения для одинаковых слов.

- Далее в методе main выводим результат — итоговый подсчет слов в формате «слово: количество».

finalWordCount.forEach((word, count) -> System.out.println(word + ": " + count)); executor.shutdown();

executor.shutdown() завершает работу пула потоков, освобождая ресурсы.

Попробуем обработать текст:

Получим такой ответ:

Он отражает количество вхождений каждого слова в предоставленном тексте с учетом регистра.

В этой реализации Shuffle и Reduce проходят в рамках одного потока. В классическом MapReduce (например, в Hadoop) эти фазы распределены по разным этапам и узлам кластера.

Код можно адаптировать для работы в реальном кластере, например с использованием Spark или Hadoop, для более масштабируемой и распределенной обработки.

Как использовать в задаче Hadoop

Используя в задаче Hadoop, нужно учесть, что работать с ним можно только на системах Linux.

Для этого нужно выполнить следующие действия:

- Настроить зависимости в pom.xml (если у вас Maven)

<dependencies> <!-- Hadoop dependencies --> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-client</artifactId> <version>3.3.0</version> </dependency> <!-- For running MapReduce jobs --> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-mapreduce-client-core</artifactId> <version>3.3.0</version> </dependency> <!-- Logging libraries (optional but recommended for Hadoop logs) --> <dependency> <groupId>log4j</groupId> <artifactId>log4j</artifactId> <version>1.2.17</version> </dependency> </dependencies>

- Установить и настроить Apache Hadoop (для использования с кластером)

После скачивания архива с официального сайта, распакуйте его и настройте переменные среды.

— Добавьте в .bashrc (или аналогичный файл конфигурации для вашей ОС).

export HADOOP_HOME=/path/to/hadoop export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

— Настройте Hadoop.

В директории HADOOP_HOME/etc/hadoop/ отредактируйте несколько файлов конфигурации:

- core-site.xml. Указать URI HDFS.

- hdfs-site.xml. Указать настройки для HDFS.

- mapred-site.xml. Указать настройки для MapReduce.

Пример настройки для локального режима:

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

- Запустить Hadoop

Чтобы запустить Hadoop в локальном режиме, выполните следующие команды:

- Форматируем HDFS (если еще не форматировали):

hdfs namenode -format

- Запускаем HDFS:

start-dfs.sh

- Запускаем YARN:

start-yarn.sh

- Загрузить файлы в HDFS

Для этого используем команду:

hadoop fs -put local_file.txt /user/hadoop/input/

- Адаптировать код для использования с Hadoop

Код для запуска также изменится. Теперь мы будем использовать Hadoop MapReduce API, а именно Mapper, Reducer и Driver классы, чтобы выполнить задачу подсчета слов в распределенной среде.

Класс Mapper

import org.apache.hadoop.io.*;

import org.apache.hadoop.mapreduce.*;

import java.io.IOException;

public class WordCountMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

@Override

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String line = value.toString();

// Разбиваем строку на слова

String[] words = line.split("\\W+");

for (String wordStr : words) {

if (!wordStr.isEmpty()) {

// Преобразуем слово в нижний регистр

word.set(wordStr.toLowerCase());

// Отправляем слово и 1 в контекст

context.write(word, one); (Map)

}

}

}

}

Класс Reducer

import org.apache.hadoop.io.*;

import org.apache.hadoop.mapreduce.*;

import java.io.IOException;

public class WordCountReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

@Override

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

// Суммируем все значения для одного слова

sum += val.get();

}

// Устанавливаем результат

result.set(sum);

// Записываем результат в контекст (Reduce)

context.write(key, result);

}

}

Класс Driver

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.*;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordCountDriver {

public static void main(String[] args) throws Exception {

// Проверка аргументов (путей для входных и выходных данных)

if (args.length != 2) {

System.err.println("Usage: WordCountDriver <input path> <output path>");

System.exit(-1);

}

// Создаем конфигурацию Hadoop

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "Word Count");

// Устанавливаем главный класс (Driver)

job.setJarByClass(WordCountDriver.class);

// Устанавливаем Mapper и Reducer

job.setMapperClass(WordCountMapper.class);

job.setReducerClass(WordCountReducer.class);

// Устанавливаем типы выходных данных для Mapper и Reducer

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

// Устанавливаем путь к входным и выходным данным

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

// Ожидаем завершения работы задачи

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

Принцип работы:

- Mapper разбивает строки на слова и создает пары (слово, 1).

- Reducer суммирует количество вхождений каждого слова.

- Driver управляет конфигурацией и выполнением задачи на кластере Hadoop.

- Собрать проект и запустить Hadoop Job

После того как вы настроили Hadoop и написали задачу, нужно собрать ваш проект. Это можно сделать с помощью команды (для Maven):

mvn clean package

После этого запустите задачу на Hadoop с помощью команды hadoop jar:

hadoop jar target/wordcount-1.0-SNAPSHOT.jar com.example.WordCountDriver /user/hadoop/input/ /user/hadoop/output/

Где:

/user/hadoop/input/ — это путь в HDFS, где лежат входные данные.

/user/hadoop/output/ — это путь в HDFS для вывода.

Теперь код работает с Hadoop, используя MapReduce для подсчета количества вхождений слов в текстовом файле.

Основное отличие в том, что мы используем Hadoop API для обработки данных в распределенной среде. Hadoop берет на себя распределение данных и управление вычислениями, а наша задача сводится к написанию Mapper, Reducer и Driver, которые выполняют логику подсчета слов.