Stable Diffusion — это модель для генерации изображений от Stability AI с открытым исходным кодом, которая преобразует текстовые описания в визуальные изображения. Модель использует диффузионный процесс для создания изображений. Stable Diffusion подходит для создания концепт-артов, иллюстраций и визуальных материалов, но результаты могут варьироваться в зависимости от сложности запроса и настроек.

Что такое Stable Diffusion простыми словами

Stable Diffusion — это мощная модель генерации изображений с открытым исходным кодом, использующая диффузионный процесс для преобразования текстовых описаний в визуальные изображения. Модель способна создавать фотореалистичные или художественные изображения на основе введенного текста, например, «футуристический город» или «пейзаж на закате».

Как работает Stable Diffusion

Stable Diffusion работает на основе концепции диффузии, где случайный шум постепенно превращается в осмысленное изображение, проходя через несколько этапов уточнения. В процессе генерации изображения система учитывает контекст, текстовые подсказки и обученные данные.

Пользователи могут настраивать модель для создания изображений с разными уровнями детализации, цвета и стиля. Чтобы добиться качественного результата, нужно экспериментировать с параметрами модели. Генерация изображений варьируется в зависимости от сложности запроса и точности настроек.

Stable Diffusion доступна как для локального использования (на мощных ПК с хорошей графикой), так и через облачные сервисы, которые позволяют обрабатывать запросы на удаленных мощностях. Ее открытый исходный код и возможности для кастомизации делают ее доступной для разработчиков, которые могут адаптировать модель для конкретных нужд. Вдобавок, система поддерживает inpainting (редактирование существующих изображений) и upscaling (увеличение разрешения).

Как пользоваться Stable Diffusion

Stable Diffusion предоставляет несколько способов использования, от базовых до более сложных, в зависимости от уровня подготовки пользователя и доступных ресурсов. Вот основные варианты.

Через консоль

Это самый гибкий способ, который подойдет пользователям с опытом работы с Python. Нужно скачать исходный код с GitHub и настроить окружение с помощью инструкций. Этот вариант подходит для тех, кто хочет интегрировать новые методы генерации изображений и детально настроить модель под свои задачи.

Преимущества: Полный контроль над настройками, возможность интеграции новых функций.

Недостатки: Требуется знание Python и настройка окружения.

Через браузер

Самый простой способ использовать Stable Diffusion без необходимости установки чего-либо. Можно работать через специализированные веб-сайты:

- Dream Studio — официальная платформа для генерации изображений.

- ClipDrop — еще один сервис для использования Stable Diffusion онлайн.

- Hugging Face — сервис с доступом к версиям модели и возможности загрузки собственных вариаций.

Эти сервисы позволяют использовать модель прямо в браузере, но могут требовать регистрации.

Преимущества: Легкость в использовании, доступность с любых устройств.

Недостатки: Медленная генерация, ограниченные возможности по настройке, зависимость от серверов.

Через графический интерфейс и установщик

Для пользователей, предпочитающих не углубляться в код, есть программы с графическим интерфейсом, такие как:

- NMKD Stable Diffusion GUI — графический интерфейс для работы с Stable Diffusion, удобный для новичков.

- Easy Diffusion — еще один простой инструмент с графическим интерфейсом.

Эти интерфейсы позволяют настраивать параметры генерации изображений через простой интерфейс, не требуя знаний в программировании. Однако эти версии могут не поддерживать все новые функции и настройки.

Преимущества: Удобный интерфейс, не нужно работать с кодом.

Недостатки: Ограниченные настройки, необходимость установки на ПК.

Через Telegram-ботов

Для быстрого и упрощенного доступа можно использовать телеграм-боты. Например, Devoid Diffusion — бот для генерации изображений по запросам.

Боты позволяют генерировать изображения по текстовым запросам без установки приложений, но у них есть свои ограничения по функциональности и настройкам.

Преимущества: Доступность с мобильных устройств, не требуется установка.

Недостатки: Ограниченные возможности, очереди ожидания.

Установка на своем компьютере

Для более стабильной работы и повышения скорости генерации можно установить Stable Diffusion на свой компьютер. Для этого потребуется видеокарта Nvidia с минимум 4 ГБ видеопамяти и достаточное количество места на диске.

Процесс установки включает скачивание и настройку программы-установщика, например, NMKD Stable Diffusion GUI — для удобного запуска на вашем ПК.После установки можно настроить параметры работы, такие как видеопамять и место для сохранения результатов.

Преимущества: Быстрая генерация, приватность данных, полный контроль.

Недостатки: Требования к аппаратному обеспечению, необходимость установки и настройки.

Как писать промпты для Stable Diffusion

Для того чтобы изображение, сгенерированное Stable Diffusion, соответствовало вашим ожиданиям, важно правильно составить текстовый запрос.

Общие советы

- Соблюдайте порядок слов. Наибольший вес в запросе будет иметь первое слово. Старайтесь начинать с наиболее важных элементов, чтобы нейросеть точно поняла, что для вас главное.

- Используйте основные категории. Промпт должен включать следующие элементы:

- Основной объект (например, человек, машина, пейзаж)

- Характер изображения (цифровая фотография, масляная живопись и т. д.)

- Стиль (сюрреализм, конструктивизм, стиль художника и т. д.)

- Детали (цвет, текстура, освещение, фон).

- Также укажите дополнительные аспекты, такие как разрешение изображения и особенности освещения. Чем конкретнее будет запрос, тем лучше будет результат.

- Будьте подробными, но не перегружайте запрос. Опишите идею как можно точнее, но избегайте перегрузки запроса деталями. Stable Diffusion обрабатывает до 75 слов, поэтому лучше избежать слишком длинных описаний. Используйте синонимы, чтобы модель точнее интерпретировала атмосферу, которую вы хотите передать.

- Используйте конкретику. Нейросеть не понимает метафор и намеков, поэтому чем конкретнее будет ваш запрос, тем точнее будет результат.

- Подражание художникам. Указывайте известных художников, чей стиль вам нравится, например, «in the style of Van Gogh». Это поможет добиться нужной стилистики.

- Пример из успешных запросов. Используйте примеры запросов других пользователей, доступных на платформах вроде PromptHero или Lexica.art, чтобы вдохновиться и адаптировать их под свои нужды.

Использование весов для слов

В запросе можно указывать «вес» для каждого слова после двоеточия. Это позволяет модели понимать, насколько важен каждый элемент. Например, если вы хотите, чтобы изображение было очень детализированным, вы можете использовать веса, например, «cat:0.7», где 0.7 — это вес, который определяет значимость слова «cat».

Настройки генерации

Помимо самого запроса, в Stable Diffusion есть несколько параметров, которые влияют на результат:

- Steps: количество шагов, которые модель будет делать для генерации изображения. Обычно рекомендуется 50 шагов.

- Classifier Free Guidance (CFG Scale): параметр, который управляет свободой интерпретации запроса. Чем выше значение (например, 12–15), тем точнее нейросеть будет следовать запросу.

- Seed: стартовая точка генерации. Использование фиксированного числа в этом параметре поможет получить похожие результаты при повторных запросах.

- Resolution: разрешение изображения. Stable Diffusion лучше всего генерирует изображения размером 512×512 пикселей.

Использование негативных промптов

Важно также указать, чего не должно быть на изображении. Для этого можно использовать второй поля — негативный промпт. Например, если вы хотите избежать определенных элементов или стилей, вы можете указать их здесь.

Формула запроса

Придерживайтесь формулы при составлении запроса:

Объект + Фон + Стиль + Дополнительные детали.

Например, запрос может выглядеть так:

«cat, sitting on a beach at sunset, realism, high detail, soft lighting».

Правильная формулировка запроса имеет решающее значение для получения качественного изображения. Экспериментируйте с настройками и деталями, чтобы добиться наилучших результатов!

Примеры использования Stable Diffusion

Stable Diffusion позволяет генерировать изображения на основе текстовых запросов, что открывает большие возможности для творчества. Вот несколько примеров запросов и типов изображений, которые можно создать с помощью этой нейросети:

Создание пейзажей

Запрос: «A serene sunset over a mountain range, vibrant colors, soft lighting, realistic»

Результат:

С помощью этого запроса можно создать фотореалистичный пейзаж, где нейросеть генерирует картину заката, на котором горы освещены мягким светом. Такие изображения идеально подходят для фонов, концепт-арта или просто для вдохновения.

Создание персонажей

Запрос: «A futuristic female astronaut, with a sleek helmet and glowing suit, cyberpunk style»

Результат: Запрос на создание персонажа в стиле киберпанк позволит получить изображение астронавта с яркими и футуристичными деталями костюма, который выглядит как часть научно-фантастической вселенной.

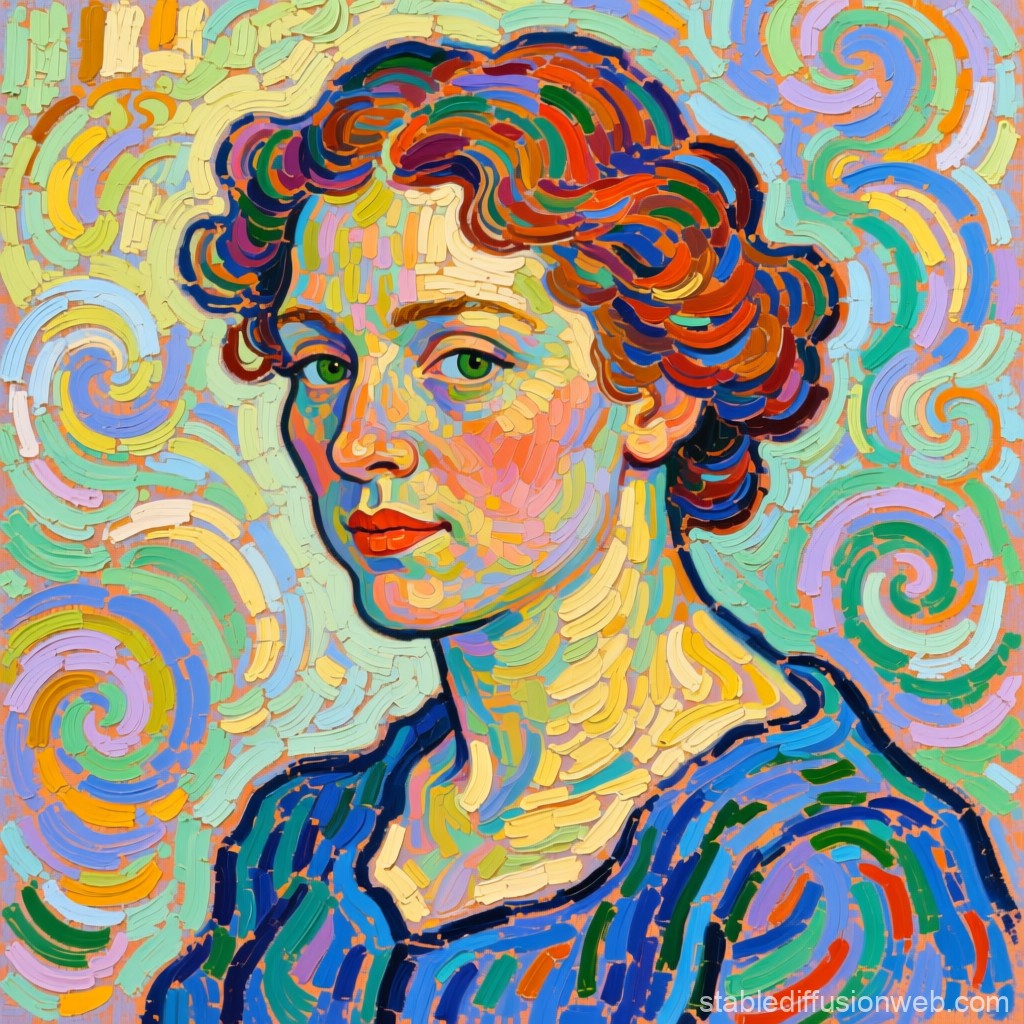

Воссоздание стиля художников

Запрос: «A portrait of a woman in the style of Vincent van Gogh, with swirling brush strokes and vivid colors»

Результат: Stable Diffusion может воссоздавать уникальные стили известных художников. В этом примере нейросеть генерирует портрет в стиле Ван Гога, с характерными вихревыми мазками и насыщенными цветами.

Генерация сюрреалистичных сцен

Запрос: «A surreal scene of a floating island with waterfalls, bright sky, and futuristic city in the distance»

Результат: С помощью этого запроса можно создать фантастическую и сюрреалистичную сцену, где элементы природы и технологии переплетаются. Это изображение отлично подойдет для концепт-артов в видеоиграх или фильмах.

Создание текстур для игр

Запрос:

«A seamless texture of cracked stone, high detail, realistic lighting»

Результат: Stable Diffusion также может генерировать текстуры для использования в играх или других цифровых проектах. Запрос для создания текстуры камня с трещинами приведет к результату, который можно использовать для моделирования 3D-объектов.

Альтернативы Stable Diffusion

Хотя Stable Diffusion — одна из самых популярных моделей для генерации изображений по тексту, существуют и другие нейросети и сервисы, которые могут стать хорошей альтернативой в зависимости от задачи. Рассмотрим основные из них.

DALL·E 3

Созданная OpenAI, эта модель умеет генерировать изображения по текстовым описаниям, часто с очень точной передачей деталей и сложных сцен.

Особенности:

- Отлично работает с человеческими персонажами и сложными композициями.

- Поддерживает «inpainting» — замену частей изображения.

- Генерация высококачественных картинок прямо в браузере через платформу OpenAI.

Применение: концепт-арт, иллюстрации, маркетинговые материалы.

MidJourney

Сервис, популярный среди дизайнеров и иллюстраторов, ориентирован на художественный стиль.

Особенности:

- Подходит для создания атмосферных и стилизованных изображений.

- Работает через Discord, что делает его удобным для совместной работы и обсуждения идей.

Применение: Визуализация идей в стиле анимации, фантастики и сюрреализма.

Leonardo AI

Платформа с акцентом на концепт-арт и игровую графику.

Особенности:

- Быстро генерирует высококачественные 3D- и 2D-элементы.

- Поддерживает доработку изображений и работу с отдельными слоями.

Применение: игры, иллюстрации персонажей, визуализация объектов.

0 комментариев